Zuletzt aktualisiert am 14. April 2025

Von 2022 bis 2023 wurden etwa 15 Milliarden KI-Bilder generiert. Doch diese Visualisierungen können nur so gut sein, wie die Bilddatenbanken, auf die sie zurückgreifen. Eine Studie hat jetzt gezeigt: KI verstärkt genderstereotype Bilder zu Technikberufen.

Text-zu-Bild-Generatoren wie DALL·E Mini können aus einfachen Texteingaben realistische Bilder generieren. Doch Diversity-Aspekte kommen dabei zu kurz. KI-Bildgeneratoren wie DALL·E Mini verstärken Geschlechter- und Ethnie-Stereotype, indem sie Frauen und People of Color systematisch unter- oder missrepräsentieren. Dass dies auch für technische Berufe gilt, hat jetzt Tim Breuer in seiner BA-Thesis belegt: Von 180 mit Tool Dall E Mini kreierten Bildern bilden nur 35 Frauen und 7 People of Colour ab. Selbst der Einsatz von diversity-sensiblen Textanweisungen kann diesem Bias nur teilweise entgegenwirken .

Der MINT-Sektor durch die Linse generativer KI

Die Untersuchungen von Tim Breuer fokussiert sich auf eigens hierfür generierte Berufsbilder aus dem MINT-Sektor (Mathematik, Informatik, Naturwissenschaften, Technik). Besonders in den Bereichen Informatik und Technik generierte das Modell fast ausschließlich weiß- und männlich-kodierte Figuren. Ein Auslöser dafür sind nicht nur die eingeschränkten Trainingsdaten, wie DALL·E Mini-Entwickler Boris Dayma im Technical Report hervorhebt, sondern auch umfassendere Aspekte wie mangelnde KI-Ethik, fehlende rechtliche Rahmenbedingungen und die geringe Diversität in Entwicklungsteams.

DALL·E Mini generiert keine Frauen für Technik- und Informatikberufe

Die Berufsbeschreibungen wurden auf Englisch formuliert, da das Modell laut Entwickler Boris Dayma für diese Sprache optimiert ist. Zudem ist Deutsch eine Genus-Sprache, was die Ergebnisse beeinflussen könnte. Aufgrund der Herkunft der Trainingsdaten werden amerikanische Berufsdemografien zum Vergleich herangezogen. Die Untersuchung ergab, dass DALL·E Mini in allen Informatik- und Technik-Berufen Frauen vollständig aus den generierten Bildern ausschloss. In den analysierten Darstellungen für Berufe wie „Software Engineer“, „Computer Scientist“ oder „IT Project Manager“ fanden sich ausschließlich männlich-kodierte Figuren, obwohl laut Daten des U.S. Bureau of Labor Statistics (2023) und Zippia Demographic Research (2024) zwischen 20.2 und 33.6 Prozent der realen Beschäftigten in diesen Feldern Frauen sind. In mathematischen Berufen zeigte sich ein ähnliches Muster mit der Ausnahme von „Math Teacher“ und „Supply Chain Manager“. Während in Berufen wie „Statistician“ oder „Business Mathematician“ Frauenanteile zwischen 36.8 und 40.8 Prozent verzeichnet sind, fanden sich in den KI-generierten Bildern auch hier keinerlei weiblich-kodierte Darstellungen. Insgesamt zeigen nur 35 von 180 generierten Bildern Frauen in MINT-Berufen.

People of Color in MINT-Berufen nahezu unsichtbar

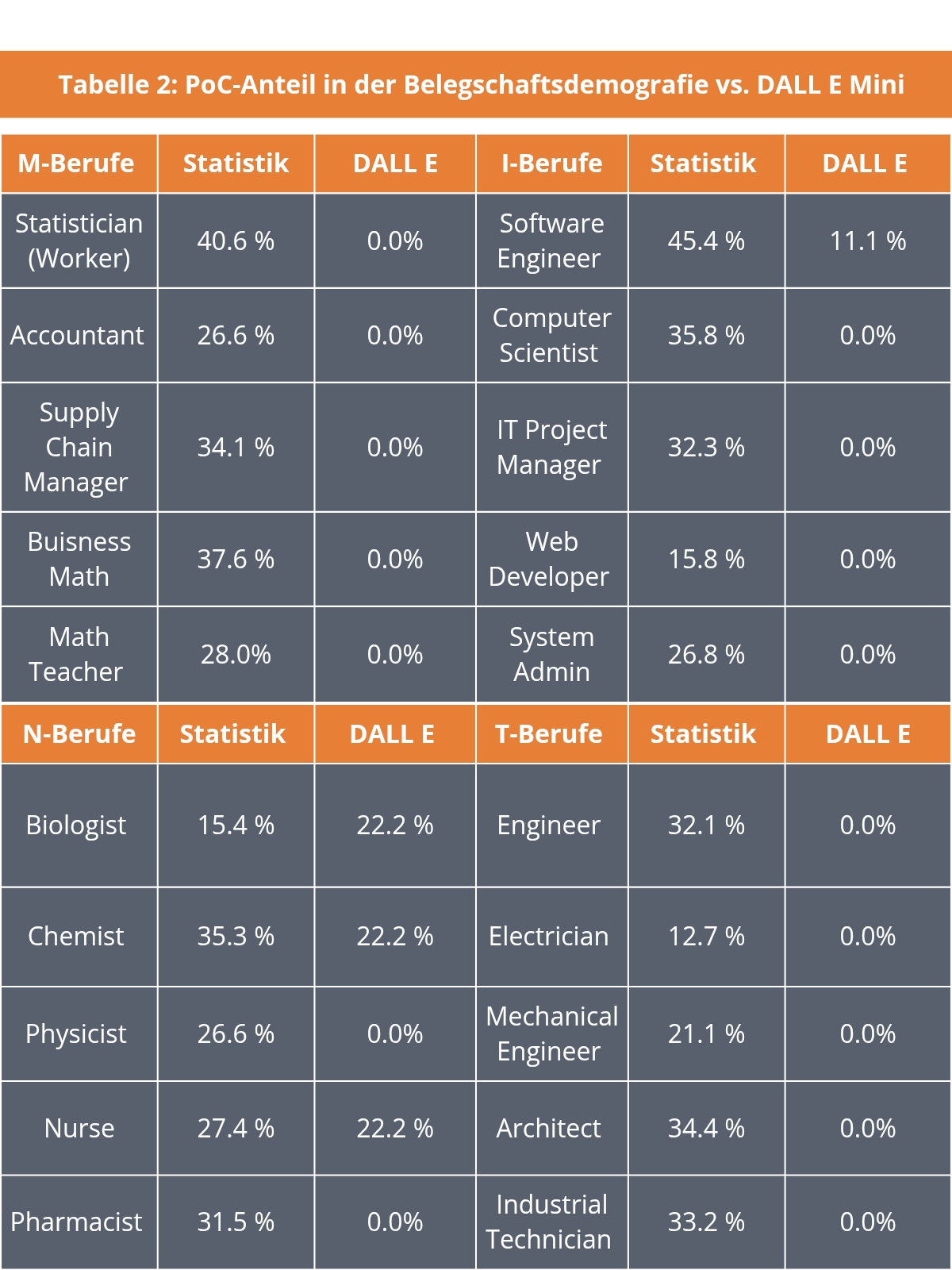

Die Unsichtbarkeit von People of Color war in den generierten Bildern ebenfalls auffällig. In allen mathematischen Berufen wie „Accountant“ oder „Math Teacher“, in denen laut Beschäftigungsstatistiken zwischen 26.6 und 40.6 Prozent der Beschäftigten PoC sind, stellte DALL·E Mini ausschließlich weiß-kodierte Figuren dar. Auch bei den Informatikberufen werden außer für „Software Engineer“ (11.1 Prozent) ausschließlich weiß-konstruierte Personen generiert. Im Technikbereich war die Verzerrung noch ausgeprägter. Obwohl in Berufen wie „Engineer“, „Electrician“ oder „Industrial Technician“ der Anteil von People of Color bis zu 34.4 Prozent beträgt, generierte das Modell durchweg weiß-konstruierte Figuren. Somit zeigen die Bilder eine intersektionale Unsichtbarkeit von Frauen und PoC im Techniksektor. Insgesamt enthielten nur 7 von 180 analysierten KI-Bildern Darstellungen von PoC, was auf eine massive Verzerrung in der Bildgenerierung hindeutet.

KI-generierte versus tatsächliche Belegschafte

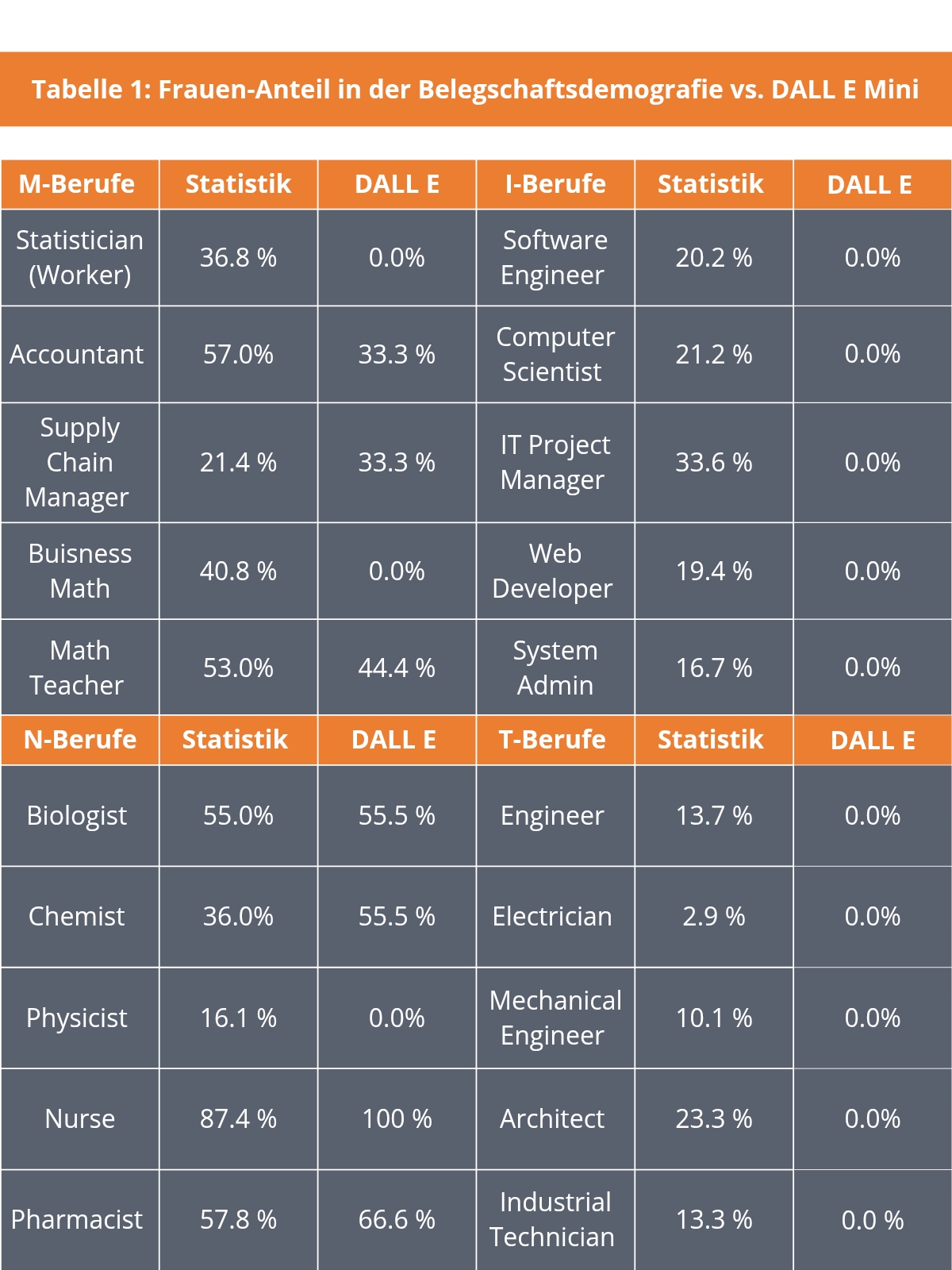

In den naturwissenschaftlichen Berufen wie „Biologist“ oder „Pharmacist“ wurden Frauen mit 44.4 bis 55.5 Prozent häufiger dargestellt, die KI näherte sich hier der realen Verteilung an – eine Ausnahme. Dies könnte darauf zurückzuführen sein, dass in diesen Feldern die weibliche Repräsentation in den Trainingsdaten bereits höher ist, da Naturwissenschaften mit dem Motivationsfaktor „Umwelt- und Klimaschutz“ attraktiver für Frauen sind. Dennoch bleibt der generelle Trend bestehen: Frauen und PoC werden in MINT-Berufsfeldern durch KI-generierte Bilder zusätzlich marginalisiert. Dies lässt sich im tabellarischen Vergleich (Tabelle 1: Frauenanteil; Tabelle 2: PoC-Anteil*) der belegschaftsdemografischen Statistik und Repräsentation in DALL·E Mini erkennen.

*Slider: Tabelle 1 zeigt für die ausgewählten zwanzig MINT-Berufe den prozentualen Frauen-Anteil der Belegschaften (basierend auf den U.S. Labor Statistics und dem Demographic Research von Zippia) im Verhältnis zur Repräsentation durch DALL E Mini. Tabelle 2 zeigt dieselbe Gegenüberstellung für den PoC-Anteil. /Quelle: Tim Breuer

Desensibilisierte Entwicklungsprozesse

Die Ursachen für diese Verzerrungen liegen primär in den Daten, mit denen DALL·E Mini trainiert wurde. Das Modell nutzt große Bild-Text-Korpora wie Conceptual Captions und Conceptual 12M, die aus bestehenden Online-Bilddatenbanken und Webseiten stammen. Diese Quellen sind nicht neutral, sondern spiegeln gesellschaftliche Ungleichheiten wider. Bei DALL·E Mini handelt sich um ein schwächeres Modell (namentlich eine „Mini“-Version von DALL·E), die einfachen Nutzungsbedingungen als Open-Access Applikationen führten trotzdem zu einer hohen Popularität als erster Berührungspunkt mit dieser Technologie.

Eine vergleichbare Studie, unter anderem von Marc Cheong – Dozent für Computer- und Informationssysteme an der University of Melbourne – klassifiziert die von DALL·E Mini generierte Figuren anhand ihres „perceived gender“ (männlich, weiblich, undefiniert) sowie ihrer „perceived racial identity“ (weiß oder nicht-weiß). Die KI generierte auch hier fast ausschließlich eindeutig männlich oder weiblich kodierte Figuren, während die tatsächliche Verteilung diverser ist. Zudem wurden Berufe mit einem hohen Frauenanteil – darunter „Waiter“, „Baker“, „Accountant“ und „Judge“ – in den KI-generierten Bildern durch einen niedrigeren Anteil weiblich kodierter Figuren dargestellt. Dass dieses Muster nicht nur auf DALL·E Mini beschränkt ist, sondern auch bei anderen Text-zu-Bild-Generatoren auftritt, belegen weitere Untersuchungen von Ranjita Naik und Besmira Nushi aus dem Microsoft Research Team.

Frühere Untersuchungen zeigten ähnliche Muster in anderen algorithmischen Systemen. Eine Studie der Forschenden Amit Datta, Michael Carl Tschantz und Anupam Datta von 2015 belegte, dass Google-Werbeanzeigen für Führungspositionen in MINT-Berufen Männern fünfmal häufiger angezeigt wurden als Frauen. Eine weitere Untersuchung des Wissenschaftlers Tolga Bolukbasi (u. a. Google DeepMind) aus dem Jahr 2016 zeigte, dass Sprachmodelle Berufe wie „Computer Programmer“ automatisch mit Männern und „Homemaker“ mit Frauen assoziierten.

Erste Korrekturmaßnahmen für eine „fairere KI“ überzeugen noch nicht

In der Studie wurde auch das Verfahren des „Prompt Engineering“ getestet, um die Umsetzbarkeit und Qualität inklusiverer Darstellung in KI-generierten Bildern zu beleuchten. So zeigte sich, dass die Eingabe „black female engineer“ dazu führte, dass DALL·E Mini ausschließlich Schwarze Ingenieurinnen generierte. Diese Methode kann Verzerrungen teilweise ausgleichen, führt jedoch zu neuen Herausforderungen. Die generierten Bilder ähneln Stockfotos, in denen die dargestellten Personen eher posierend als in realen Arbeitssituationen gezeigt werden. Zudem zeigte sich, dass das Modell Berufe mit bestimmten Bildkonzepten verknüpftn. So führte die Eingabe „computer scientist who is a woman“ dazu, dass Frauen in Laborkitteln am PC dargestellt wurden – nicht Informatikerinnen. Das deutet auf eine Fehlinterpretation durch erlernte Wort-Bild-Beziehungen hin.

Ein weiteres Problem zeigt sich in aktuellen KI-Korrekturmaßnahmen. Google hat wann? versucht, durch algorithmische Anpassungen die Diversität in KI-Bildgeneratoren zu erhöhen. Dies führte jedoch zu umstrittenen Ergebnissen. Das Modell „Gemini“ stellte historische Figuren wie die amerikanischen Gründerväter und Kolonialherren revisionistisch als Schwarz-konstruiert da. Das US-Medium „Wired“ beobachtete bereits, dass diese Art der Korrektur rechtspolitische Shitstorms um Diversität & Inklusion („DEI“) anheizen kann. Die strukturellen Probleme in der KI-Entwicklung werden so nicht nachhaltig gelöst.

Ethik-Teams für KI-Entwicklungsprozesse

Ebenso können interdisziplinäre Ethik-Teams stärker in den Entwicklungsprozess von KI-Technologien einbezogen werden, um potenzielle Diskriminierungen frühzeitig zu minimieren. Hierbei könnte eine engere Zusammenarbeit mit den Geisteswissenschaften fördelich sein.

Darüber hinaus könnte eine bessere Kennzeichnung von KI-generierten Bildern dazu beitragen, das Bewusstsein für mögliche Verzerrungen zu schärfen. Da KI-Systeme zunehmend für die Erstellung medialer Inhalte genutzt werden, erscheint es wichtig, dass Nutzer*innen sich der potenziellen Einflussfaktoren bewusst sind. Hier könnten Schulungen zu KI-Ethik in der Medienbildung Abhilfe schaffen.

Zu der Studie

Die Arbeit verwendet eine qualitative Inhaltsanalyse nach Mayring, um die Repräsentation von Vielfalt in KI-generierten Bildern von MINT-Berufen zu untersuchen. Dazu wurden zwanzig englische Prompts erstellt, die jeweils neun Bilder generierten. Die untersuchten Kategorien umfassten Genderattribution und People of Color (PoC), wobei visuelle Merkmale wie Kleidung, Frisur, Hautfarbe und physische Merkmale analysiert wurden. Die Bildauswertung erfolgte durch eine manuelle Kodierung basierend auf einem deduktiven Kodierleitfaden. Die Ergebnisse wurden tabellarisch aufbereitet und qualitativ interpretiert, um mögliche Verzerrungen und den Einfluss gezielter sprachlicher Anpassungen (Prompt-Engineering) auf die Darstellung von MINT-Berufen zu bewerten.

Eine Aufbereitung der Arbeit wurde als wissenschaftlicher Artikel in Zusammenarbeit mit Prof.’in Dr.’in Susanne Keil im 55. Journal des Netzwerks Frauen- und Geschlechterforschung NRW zum Themenschwerpunkt „Künstliche Intelligenz und Geschlecht“ veröffentlicht.

/ Tim Breuer